准备工具

- Ollama:用于简化大型语言模型(LLM)的本地部署和使用,可以同时支持多个大模型,开发者能够方便地在本地环境中运行和测试不同的语言模型,简单的说就是相当于一个容器。

- 官网地址:https://ollama.com/

- Ollama:用于简化大型语言模型(LLM)的本地部署和使用,可以同时支持多个大模型,开发者能够方便地在本地环境中运行和测试不同的语言模型,简单的说就是相当于一个容器。

- ChatBox AI:一款用于接入各种大模型的客户端,可以在使用大模型AI时更方便、美观。就是一个UI客户端,用起来更方便快捷。

- 官网地址:https://chatboxai.app/zh

- ChatBox AI:一款用于接入各种大模型的客户端,可以在使用大模型AI时更方便、美观。就是一个UI客户端,用起来更方便快捷。

下载安装Ollama

- 首先先下载Ollama,进入官网,官网地址:https://ollama.com/,点击Download

- 这里选择自己电脑或者服务器的系统,我的是Windows系统就选择了Windows端下载

- 下载好了就是安装了,注意Ollama默认安装是在C盘的,以及下载的大模型数据包也是默认在C盘,所以一定要注意自己C盘的存储空间够用,当然我们也有方式改变他的安装路径的(https://www.suyehe.com/?s=自定义Ollama安装路径),如果不想折腾的可以直接点击安装就可以了。

- 然后Ollama就会进入安装,点击Install后,Ollama安装好了就会自动启动。

- 安装好Ollama后Windows+R,输入CMD进入命令窗口

- 输入:ollama -v 有版本号就说明安装好了,在任务栏右下角有个羊驼的图标。

下载DeepSeek R1模型

- 在Ollama官网(https://ollama.com/)点击Models,选择deepseek-r

- 这里是选择DeepSeek蒸馏后的密集模型,注意这里的模型要根据自己的电脑性能来下载,如果资源不足,下载了也会跑不起来,我这里我选择的是第一个最小的模型。数字越大,代表参数越多,所需资源也越多,1.5b=15亿参数

- 如图所示,复制Ollama选中模型对应的下载命令。

然后回车开始下载,这里略过下载过程,这里是下载完成后的截图。

然后回车开始下载,这里略过下载过程,这里是下载完成后的截图。

但是这样在CMD窗口使用很不方便和美观,接下来我们就会用到ChatBox接入大模型了

安装ChatBox AI并接入DeepSeek

- 下载ChatBox AI,https://chatboxai.app/zh,也可以使用网页版的,这里我下载了客户端,安装过程略过。

- 下载ChatBox AI,https://chatboxai.app/zh,也可以使用网页版的,这里我下载了客户端,安装过程略过。

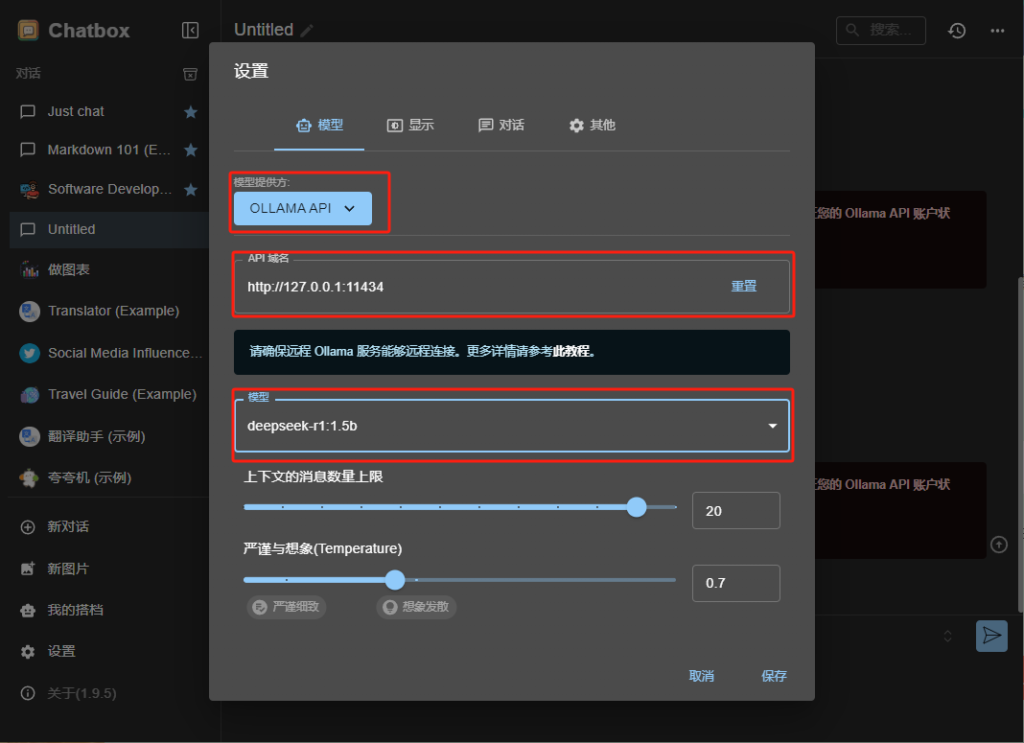

- 选择Ollama API后,然后选择我们下载好的DeepSeek模型,这里如果大家还有其他模型也可以选择对应的模型。

- 选择Ollama API后,然后选择我们下载好的DeepSeek模型,这里如果大家还有其他模型也可以选择对应的模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

然后回车开始下载,这里略过下载过程,这里是下载完成后的截图。

然后回车开始下载,这里略过下载过程,这里是下载完成后的截图。

暂无评论内容